基于先前名为UniGen的模型,苹果的一个研究团队正在展示UniGen 1.5,这是一个能在单一模型中处理图像理解、生成和编辑的系统。以下是详细信息。

基于原版UniGen

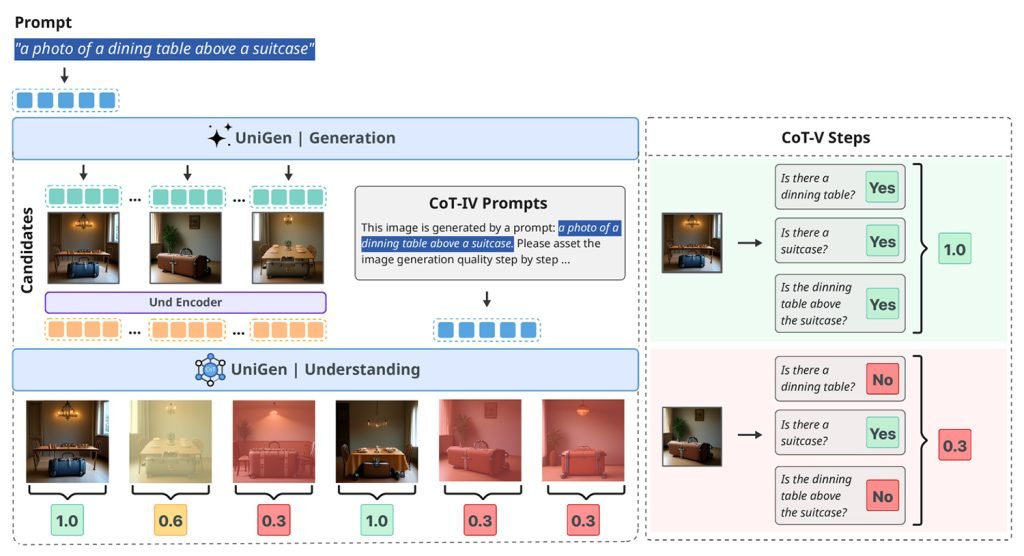

去年五月,苹果的一个研究团队发表了一项名为《UniGen:用于统一多模态理解和生成的增强训练与测试时策略》的研究。

在那项工作中,他们引入了一个统一的多模态大语言模型,能够在单一系统中同时进行图像理解和图像生成,而不是为每个任务依赖单独的模型。

现在,苹果发布了这项研究的后续工作,论文标题为《UniGen-1.5:通过强化学习中的奖励统一增强图像生成和编辑》。

UniGen-1.5详解

这项新研究通过向模型添加图像编辑功能来扩展UniGen,仍然在单一统一框架内,而不是将理解、生成和编辑拆分到不同系统中。

在单一系统中统一这些功能具有挑战性,因为理解和生成图像需要不同的方法。然而,研究人员认为,统一模型可以利用其理解能力来提高生成性能。

据他们称,图像编辑的主要挑战之一是模型往往难以完全掌握复杂的编辑指令,尤其是当变化微妙或高度特定时。

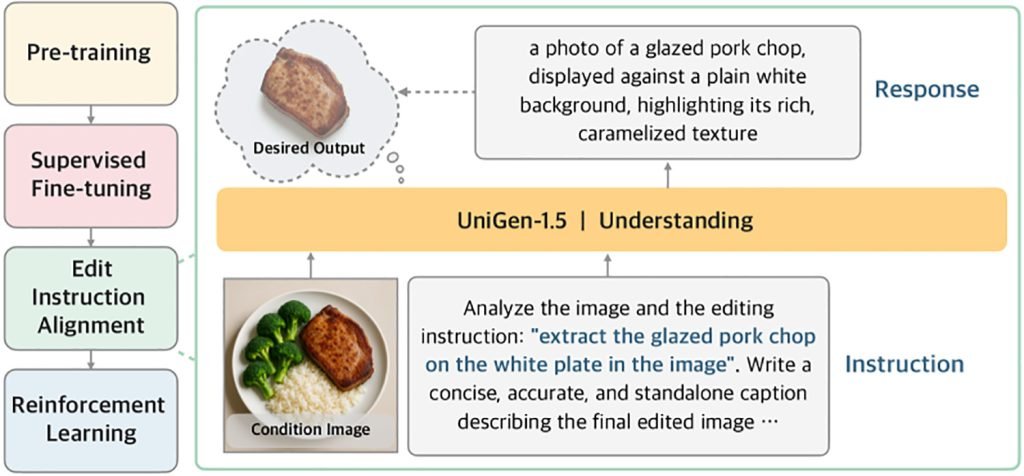

为了解决这个问题,UniGen-1.5引入了一个新的训练后步骤,称为编辑指令对齐:

“此外,我们观察到,在监督微调后,模型由于对编辑指令的理解不足,在处理多样编辑场景时仍然不足。因此,我们提出编辑指令对齐作为一个轻量的后SFT阶段,以增强编辑指令与目标图像语义之间的对齐。具体来说,它以条件图像和指令作为输入,并通过文本描述优化预测目标图像的语义内容。实验结果表明,这个阶段对提升编辑性能非常有益。”

换句话说,在通过强化学习(通过奖励更好输出和惩罚更差输出来训练模型)要求模型改进其输出之前,研究人员首先训练模型根据原始图像和编辑指令推断出编辑后图像应包含的详细文本描述。

这个中间步骤帮助模型在生成最终图像之前更好地内化预期的编辑。

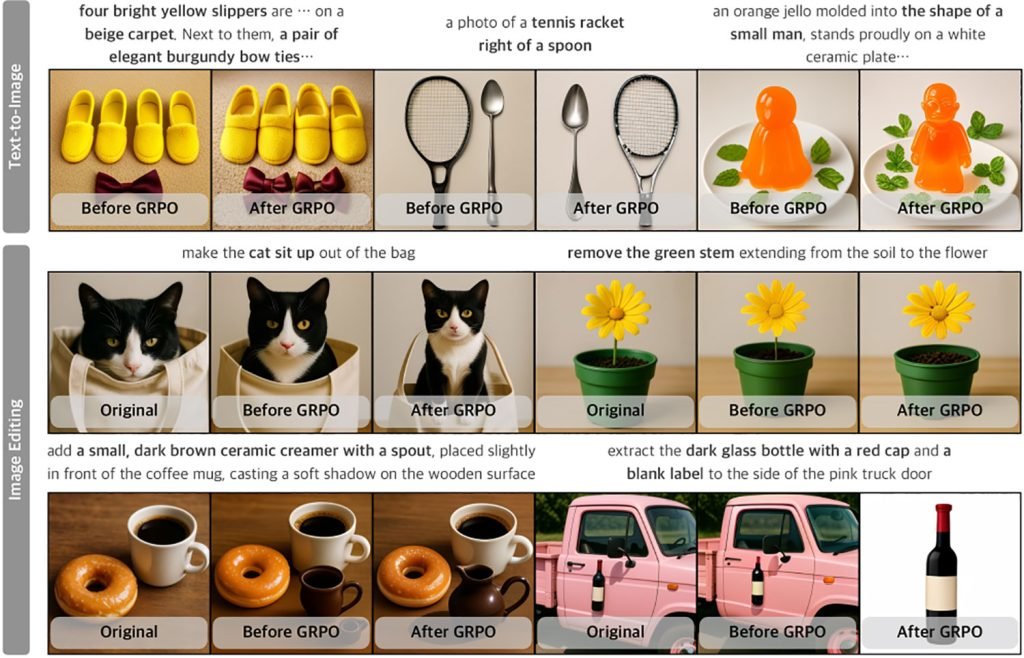

然后,研究人员以一种可以说是论文最重要贡献的方式使用强化学习:他们对图像生成和编辑使用相同的奖励系统,这以前是具有挑战性的,因为编辑范围可能从微小调整到完全转换。

因此,当在几个行业标准基准测试中评估模型遵循指令、保持视觉质量和处理复杂编辑的能力时,UniGen-1.5要么匹配要么超越了多个最先进的开源和专有多模态大语言模型:

通过上述努力,UniGen-1.5为推进统一MLLM的研究提供了更强的基线,并在图像理解、生成和编辑基准上建立了竞争性能。实验结果表明,UniGen-1.5在GenEval和DPG-Bench上分别获得0.89和86.83分,显著优于近期方法如BAGEL和BLIP3o。在图像编辑方面,UniGen-1.5在ImgEdit上获得4.31的总分,超越了近期开源模型如OminiGen2,并与专有模型如GPT-Image-1相当。

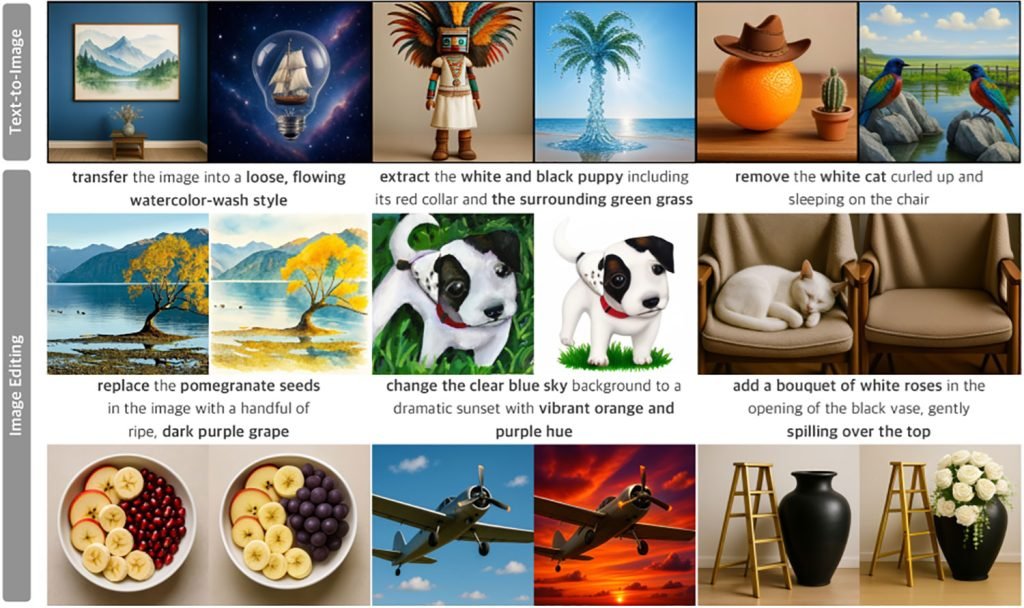

以下是UniGen-1.5的文本到图像生成和图像编辑功能的一些示例(遗憾的是,研究人员似乎错误地裁剪了第一张图中文本到图像部分的提示):

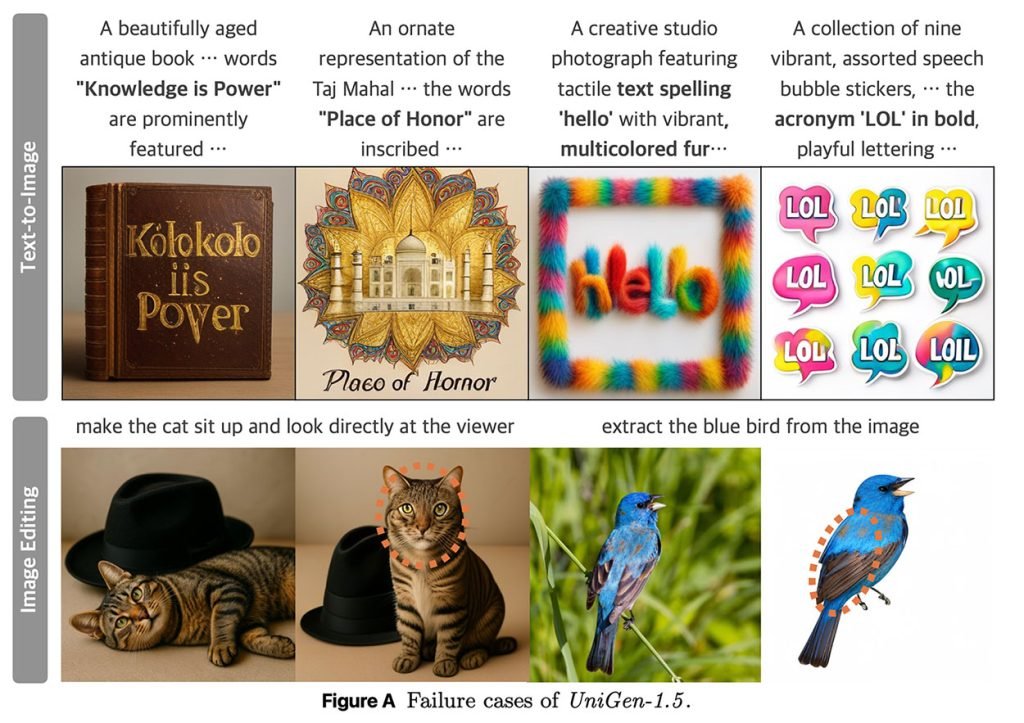

研究人员指出,UniGen-1.5在文本生成以及某些情况下的身份一致性方面存在困难:

图A展示了UniGen-1.5在文本到图像生成和图像编辑任务中的失败案例。在第一行,我们展示了UniGen-1.5未能准确渲染文本字符的实例,因为轻量级离散解标记器难以控制文本生成所需的细粒度结构细节。在第二行,我们展示了两个身份发生可见变化的示例,用圆圈突出显示,例如猫面部毛发纹理和形状的变化,以及鸟类羽毛颜色的差异。UniGen-1.5需要进一步改进以解决这些限制。

您可以在此处找到完整研究。