苹果研究人员开发出一款AI模型,通过将基于扩散的图像模型直接集成到相机图像处理流程中,显著改善极暗照片效果,使其能从原始传感器数据中还原通常丢失的细节。以下是具体实现方式。

极暗环境照片的拍摄难题

您可能曾在昏暗环境下拍摄,得到充满颗粒状数字噪点的照片。

这源于图像传感器未能捕捉足够光线。

为弥补此问题,苹果等公司一直采用图像处理算法,但这类算法常被批评会产生过度平滑的油画效果,导致精细细节丢失或重构为难以辨识的内容。

DarkDiff解决方案

为解决此问题,苹果与普渡大学的研究人员共同开发了名为DarkDiff的模型。在一项题为《DarkDiff:通过扩散模型重定向推动低光原始图像增强》的研究中,他们如此阐述:

在极端低光条件下实现高质量摄影对数码相机而言颇具挑战但意义重大。随着计算硬件进步,传统相机图像信号处理器算法正逐渐被能更智能增强噪点原始图像的高效深度网络取代。然而,现有基于回归的模型常追求最小化像素误差,导致低光照片或深阴影区域过度平滑。近期研究尝试通过从头训练扩散模型来突破此限制,但这些模型仍难以还原清晰图像细节与准确色彩。我们引入一种新颖框架,通过将预训练生成扩散模型重定向用于相机ISP来增强低光原始图像。大量实验表明,在三个高难度低光原始图像基准测试中,我们的方法在感知质量上超越了现有最佳技术。

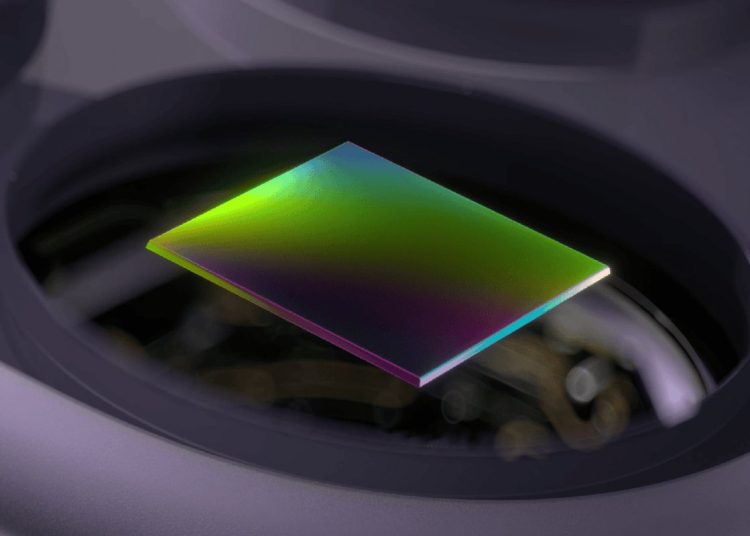

换言之,他们并未在后期处理阶段应用AI,而是将Stable Diffusion(一个基于数百万图像训练的开源模型)重定向,使其能根据照片整体上下文理解暗部应有细节,并将其集成到图像信号处理流程中。

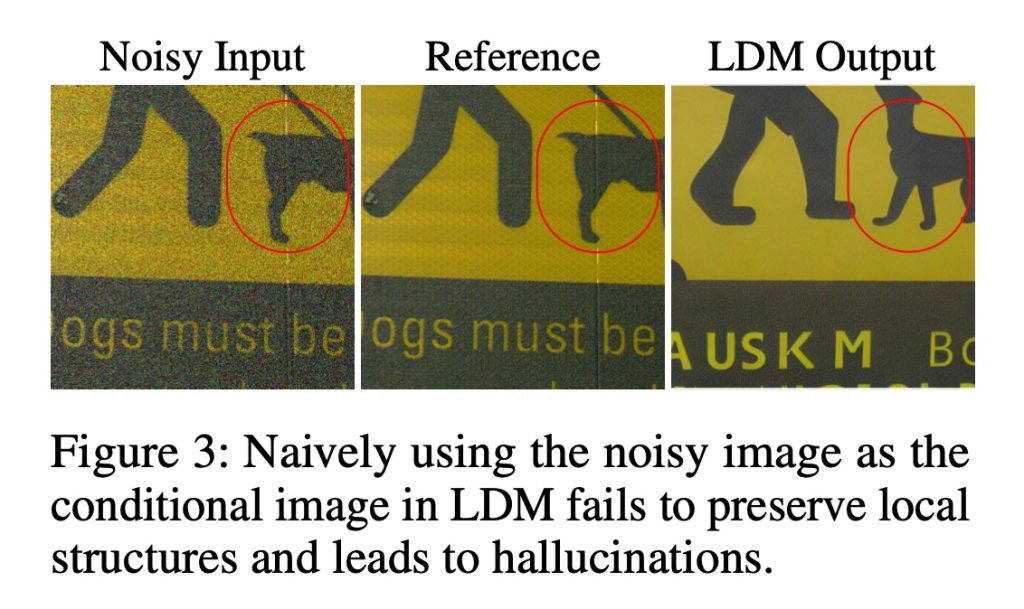

实际上,该方法引入了一种对局部图像区域计算注意力的机制,有助于保留局部结构并减少幻觉效应,如下方图像所示,其中重构AI完全改变了图像内容。

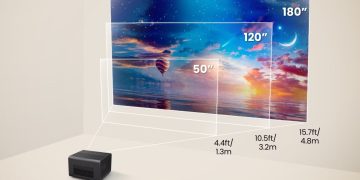

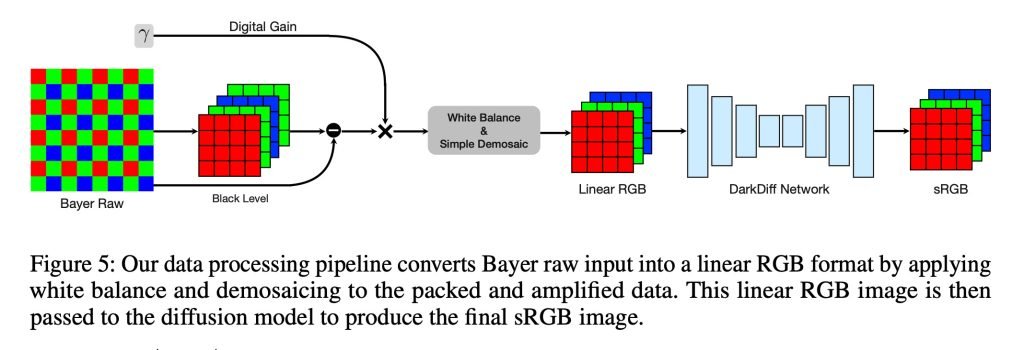

通过此方法,相机ISP仍负责处理原始传感器数据所需的早期处理,包括白平衡与去马赛克等步骤。随后DarkDiff在此线性RGB图像上运行,进行去噪并直接生成最终sRGB图像。

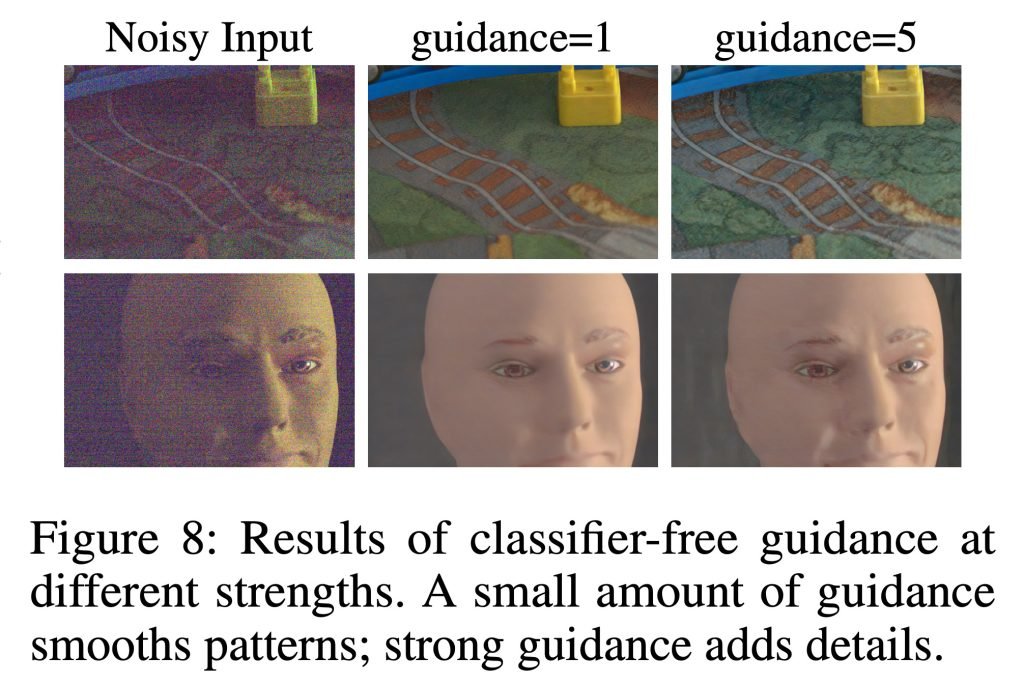

DarkDiff还采用一种称为无分类器引导的标准扩散技术,基本控制模型在遵循输入图像与所学视觉先验之间的平衡强度。

引导强度较低时,模型生成更平滑的图案;增强引导则促使生成更锐利的纹理与精细细节(同时也会增加产生伪影或幻觉内容的风险)。

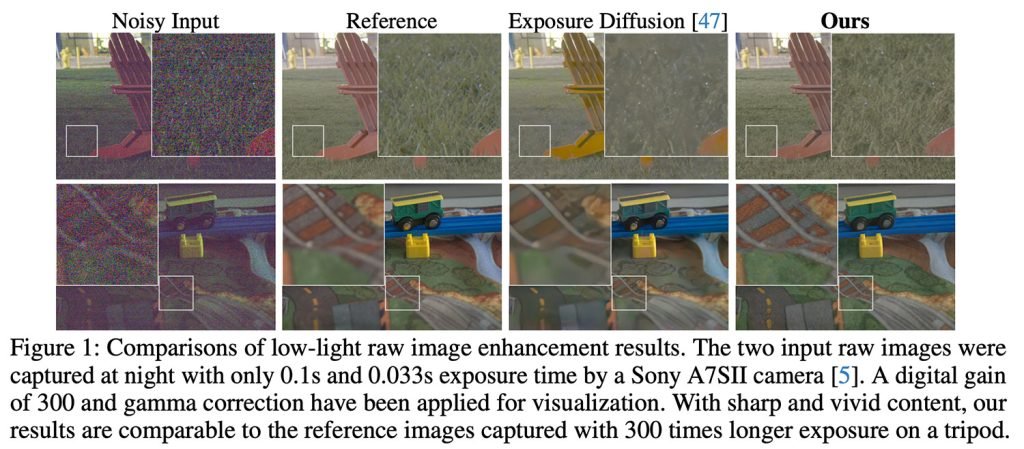

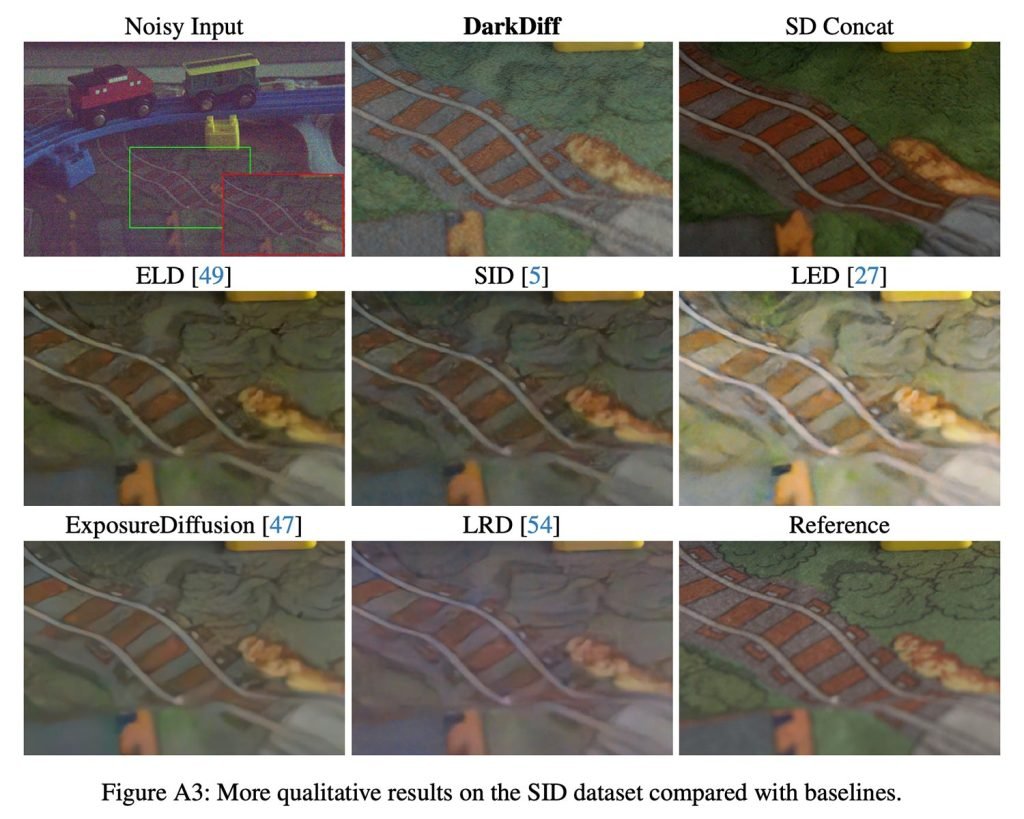

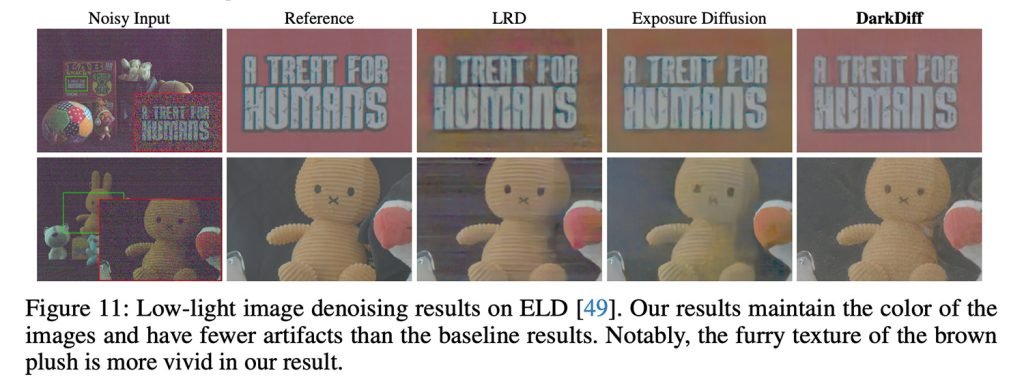

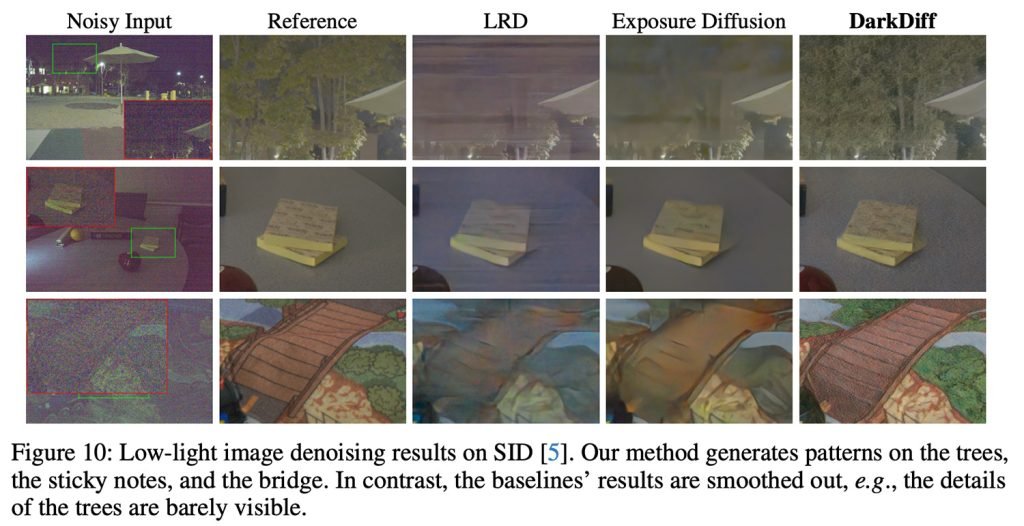

为测试DarkDiff,研究人员使用索尼A7SII等相机在极低光环境下拍摄真实照片,并将结果与其他原始图像增强模型及基于扩散的基线(包括ExposureDiffusion)进行对比。

测试图像于夜间拍摄,曝光时间短至0.033秒,并将DarkDiff增强版本与三脚架上曝光时间延长300倍的参考照片进行比较。

以下为部分结果(建议查阅原研究以观看完整质量图像):

DarkDiff仍存局限性

研究人员指出,其基于AI的处理速度显著慢于传统方法,且可能需要云端处理以弥补高昂计算需求——若在手机上本地运行会快速耗尽电量。此外,他们还提到在低光场景中非英语文本识别的限制。

需注意的是,研究中并未暗示DarkDiff会很快应用于iPhone。但这项工作彰显了苹果在计算摄影领域持续投入的创新焦点。

近年来,随着用户对相机功能的需求超越设备物理硬件的限制,这已成为整个智能手机市场日益重要的关注领域。

欲阅读完整研究并查看DarkDiff与其他去噪方法的更多对比,请点击此链接。