苹果智能版Siri可以说严重迟到,简直晚得离谱。这很大程度上是因为苹果在自研AI模型上遇到了巨大困难。可以说,苹果一方面舍不得砸大钱搞AI,另一方面他们对隐私的极致坚持也让模型训练变得异常艰难——苹果根本就没有足够的数据。

然而,这次的“迟到”居然带来了意想不到的好处。

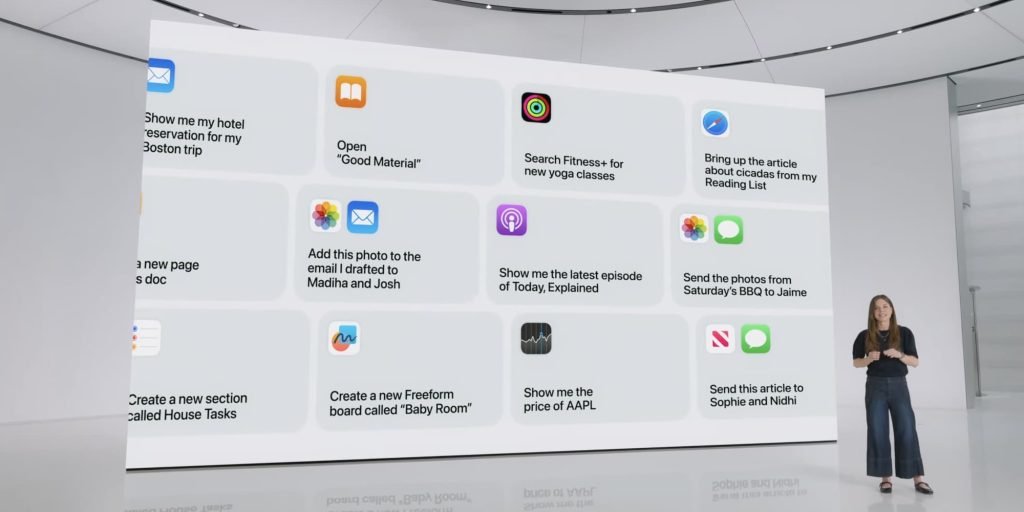

本周,苹果和谷歌宣布:Gemini模型将运行在苹果的私有云计算服务器上,为未来的苹果智能功能提供支持,包括WWDC24上公布的全新Siri。

虽然最耗算力的功能将由云端接管,但本地模型依然会保留重要角色。正如WWDC24公布时所说,苹果智能需要A17 Pro或更新的芯片,这意味着当初只有最新、最高端的机型才能体验:iPhone 15 Pro 和 iPhone 15 Pro Max。

现在,远超想象的更多人能用上苹果智能Siri

时间过去这么久,带来最直接的变化就是:能用苹果智能的设备数量暴增。

过去两年内买过任何一款iPhone 16或iPhone 17系列的用户,再加上原本就拥有iPhone 15 Pro的人,现在全都能使用苹果智能。

目前支持苹果智能的iPhone型号已经达到11款,而且这些机型都已经上市相当长时间了。而最初发布时,只有2款支持(如果算上刚发布的iPhone 16系列,也才6款)。

这变化非常关键。苹果智能刚推出时,几乎成了iPhone 16系列的专属卖点。现在,它只是一个免费的软件更新,就能覆盖如今占iPhone用户群相当大比例的设备。

总结

目前还很难深入讨论全新苹果智能功能的细节,因为很多都尚未正式公布。即使谷歌Gemini通过私有云计算接管大部分Siri请求,本地模型仍然会承担大量工作。

但无论具体功能最终依赖本地还是云端,苹果大概率会继续坚持一个原则:所有苹果智能功能,都必须在一台能够运行本地模型的设备上才能完整体验。

等到今年春季iOS 26.4带来全新Siri,再到iOS 27陆续推送更多苹果智能功能时,故事的基调将完全不同——因为届时将有海量iPhone用户真正能用上它。当然,前提是一切都顺利才行。